robots.txt 또는 로봇 메타 태그를 로봇 배제 프로토콜 또는 로봇 배제 표준이라고 합니다. 로봇 메타 태그에 관해 질문하시는 분들이 많아서 기본 개념 정도만 간단하게나마 정리해 보았습니다.

정확하게는 robots.txt(크롤링 제어)와 로봇 메타 태그(인덱싱 제어)를 구분해야겠지만 여기서는 복잡한 것들은 제외하고 일반인이 이해하기 쉽게 결과적인 것만 설명하려고 합니다.

생각보다 많은 분들이 티스토리에서 로봇 메타 태그를 적용하고 있고 로봇 메타 태그를 적용해야지만 검색엔진 최적화 또는 검색 노출에 도움이 되다고 알고 있는 것 같습니다.

robots.txt와 로봇 메타 태그

위키백과 로봇 배제 표준

로봇 배제 표준(robots exclusion standard), 로봇 배제 프로토콜(robots exclusion protocol)은 웹 사이트에 로봇이 접근하는 것을 방지하기 위한 규약으로, 일반적으로 접근 제한에 대한 설명을 robots.txt에 기술한다.

robots.txt 파일 또는 로봇 메타 태그는 로봇 배제 표준으로 검색엔진 로봇이 내 블로그에 방문했을 때 수집해도 되는 것과 수집해서는 안 되는 것 또는 색인해도 되는 것과 안 되는 것들을 알려주는 지침으로 검색엔진 봇을 제어하는 용도로 사용됩니다.

로봇 배제에 대한 지침 즉, 로봇 텍스트 파일이나 로봇 메타 태그가 없으면 검색엔진 로봇은 내 사이트의 모든 정보를 수집해도 좋다고 간주하고 검색에 반영되면 안 되는 특정한 페이지, 관리자 페이지 또는 개인 정보와 관련된 게시글 등까지도 검색에 반영시키는 문제가 발생하게 됩니다.

특히 구글 봇은 다른 검색엔진과 다르게 웹사이트의 소유자가 웹 마스터 도구 등을 이용해 수집 요청을 하지 않아도 모든 웹사이트에 주기적으로 방문해 크롤링을 하고 정보를 수집해 색인 생성 후 검색에 반영하고 있습니다.

그래서 위 와 같은 일을 방지하기 위해 로봇 배제 표준이라는 robots.txt 파일 또는 로봇 메타 태그를 이용해 검색엔진 로봇들을 제어하게 됩니다.

결론적으로 내 블로그나 웹사이트의 모든 정보를 수집해 가길 원한다면 robots.txt 파일 또는 로봇 메타 태그를 사용하지 않아도 된다는 것입니다. 물론 robots.txt 파일의 경우 검색 수집과는 별개로 검색엔진 최적화 구성요소 중 하나이기 때문에 루트 디렉터리에 위치시켜야 합니다.

티스토리 로봇 메타 태그

User-agent: *

Disallow: /owner

Disallow: /manage

Disallow: /admin

Disallow: /oldadmin

Disallow: /search

Disallow: /m/search

Disallow: /m/admin

Disallow: /like

Allow: /

User-agent: Mediapartners-Google

Allow: /

User-agent: bingbot

Crawl-delay: 30티스토리에서 제공하고 있는 robots.txt 파일을 간략하게 해석해 보겠습니다.

- "User-agent: *" 모든 검색 엔진

- "Disallow: /owner" 관리자 페이지 수집 불허용

- "Allow: /" 모든 페이지 수집허용

- "User-agent: Mediapartners-Google" 애드센스 봇은 모든 페이지 수집 허용

- "User-agent: bingbot" "Crawl-delay: 30" 빙봇은 방문 시 크롤링 지연 지시를 따른다.(수집 주기)

- 모든 검색엔진은 수집을 허용하지 않는 "Disallow"명령이 붙은 페이지를 제외하고 "Allow: /" 모든 주소의 수집을 허용한다.

- 애드센스 봇은 비검색 로봇이라 모든 페이지에 접근해도 됩니다.

- 빙봇에서는 Crawl-delay(크롤링 지연)이라는 지시문이 있습니다. 크롤링 지연 지시문을 따르는 검색엔진은 빙이 대표적입니다. 구글과 네이버는 크롤링 지연 지시문을 따르지 않고 웹 마스터 도구에서 수집 주기를 설정할 수 있습니다.

robots.txt 파일은 로봇의 크롤링 제어하는 웹사이트의 전체 지시 내용을 담아 놓습니다. 그리고 로봇 메타 태그는 특별한 경우가 아닌 이상 페이지마다 robots.txt 파일과 다른 지시를 할 때 또는 크롤링은 허용하지만, 색인 생성은 거부할 때 사용합니다.

한 가지 예를 들어 보겠습니다. 티스토리에서는 robots.txt 파일을 블로거가 직접 조작할 수가 없습니다. 색인 거부를 원할 경우 로봇 메타 태그를 이용해야 합니다.

robots.txt 파일에 모든 로봇에게 크로링(수집)을 허용했는데 예외적으로 네이버 검색 색인은 제외하고자 한다면 로봇 메타 태그를 이용해 <meta name="Yeti" content="noindex, nofollow">라고 하면 됩니다.

간단한 것 같지만 설명하자니 조금은 복잡해 지내요.

참고 사항

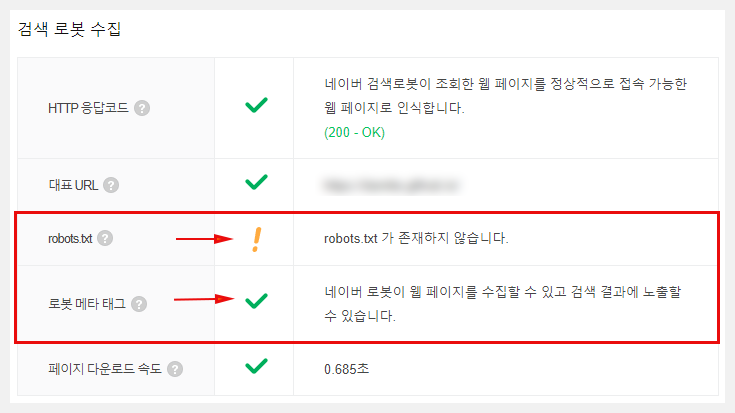

보통 구글보다는 네이버 검색엔진에 대해 더 많이 신경 쓰시는 것 같아 보여 주기 위한 한 가지 실험을 했습니다.

위 이미지를 보시면 robots.txt 파일이 없기 때문에 robots.txt가 존재하지 않습니다.라고 되어 있습니다.

반면 로봇 메타 태그도 없지만 로봇 메타 태그에는 초록색 체크 표시와 함께 "네이버 로봇이 웹 페이지를 수집할 수 있고 검색 결과에 노출할 수 있습니다."라고 되어 있습니다.

결과적으로 robots.txt 파일과 로봇 메타 태그 둘 다 없어도 네이버 검색엔진은 구글 봇과 마찬가지로 내 블로그의 글을 수집해서 검색 결과에 노출한다는 것입니다.

여기서 말씀드리고 싶은 핵심은 둘 다 없어도 검색 노출에는 문제가 없습니다. 하지만 robots.txt 파일이 없으면 네이버는 노란색 느낌표가 표시됩니다.